WordPress ist an sich ein Blogsystem, das schon sehr viel richtig macht, wenn es um die Optimierung für die Suchmaschine Google geht. Leider gibt es aber eine Kleinigkeit, die Google jetzt weniger gut findet: Seit der WordPress Version 3.6.1 liefert ein WordPress-Blog automatisch eine robots.txt Datei aus, die es selbst generiert, wenn der User keine im Root-Verzeichnis angelegt hat. An sich eine gute Idee, aber damit haben seit einigen Wochen viele Webmaster eine Google-Fehlermeldung in der Google Search Console (früher Google Webmastertools) erhalten, die sie sich nicht erklären können.

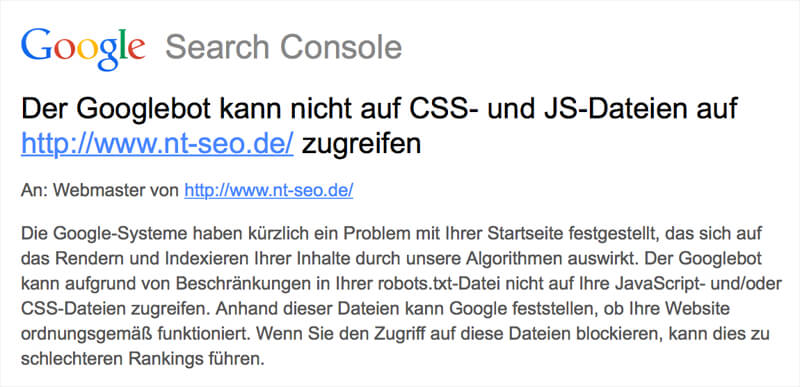

Wortlaut der Meldung in der Search Console

Der Googlebot kann nicht auf CSS- und JS-Dateien auf https://www.nt-seo.de/ zugreifen

An: Webmaster von https://www.nt-seo.de

Die Google-Systeme haben kürzlich ein Problem mit Ihrer Startseite festgestellt, das sich auf das Rendern und lndexieren Ihrer Inhalte durch unsere Algorithmen auswirkt. Der Googlebot kann aufgrund von Beschränkungen in Ihrer robots.txt-Datei nicht auf Ihre JavaScript- und/oder CSS-Dateien zugreifen. Anhand dieser Dateien kann Google feststellen, ob Ihre Website ordnungsgemäß funktioniert. Wenn Sie den Zugriff auf diese Dateien blockieren, kann dies zu schlechteren Rankings führen.

Warum nun die Warnmeldung von Google?

Die Meldung von Google erscheint, weil die von WordPress generierte robots.txt-Datei bestimmte Ressourcen und Pfade für den Google-Bot sperrt:

User-agent: * Disallow: /wp-admin/ Disallow: /wp-includes/

Durch diese Einträge werden Ressourcen im Ordner wp-includes gesperrt. Dies betrifft auch .js und .css Dateien, die Google gerne crawlen würde.

Schlechte Rankings wegen robots.txt?

Man kann es kaum glauben, aber Google „droht“ mit schlechten Rankings, wenn man in seiner robots-Datei Ressourcen wie .css und .js Dateien sperrt. Der Grund dafür ist vermutlich, dass einige Backhat-Optimierer in diesen Dateien Tricks einbauen, um SEO-Texte oder Linklisten unsichtbar zu machen. Bei den meisten WordPress-Nutzern dürfte dies aber nicht der Fall sein. Trotzdem muss man mit schlechteren Google-Rankings rechnen, wenn man die Dateiendungen weiterhin für den Google-Bot sperrt.

Lösung: WordPress aktualisieren oder robots.txt anlegen

Nun gibt es zwei Möglichkeiten, das Problem zu beheben. Möglichkeit eins ist, dass man auf eine aktuelle Version von WordPress aktualisiert. Soweit ich sehen konnte, wird ab WordPress 4.2.4 nur noch der Pfad „wp-admin“ in der robots.txt gesperrt. Damit sollte die Warnmeldung auch erledigt sein.

Lösung zwei ist das Anlegen einer robots.txt im Hauptverzeichnis der Webseite. Ich habe dies vorgezogen, um vor zukünftigen Überraschungen sicher zu sein – wer weiss, ob sich die von WordPress automatisch generierte Datei nicht doch irgendwann mal wieder ändert und Fehler hervorruft? Ich habe aus dem Grund in den Webseiten meiner Kunden die Datei robots.txt angelegt und einfach leer gelassen. Damit kann Google auf die komplette Webseiten zugreifen.

Die Fehlermeldung kann man dann in der Google Search Console als erledigt markieren.